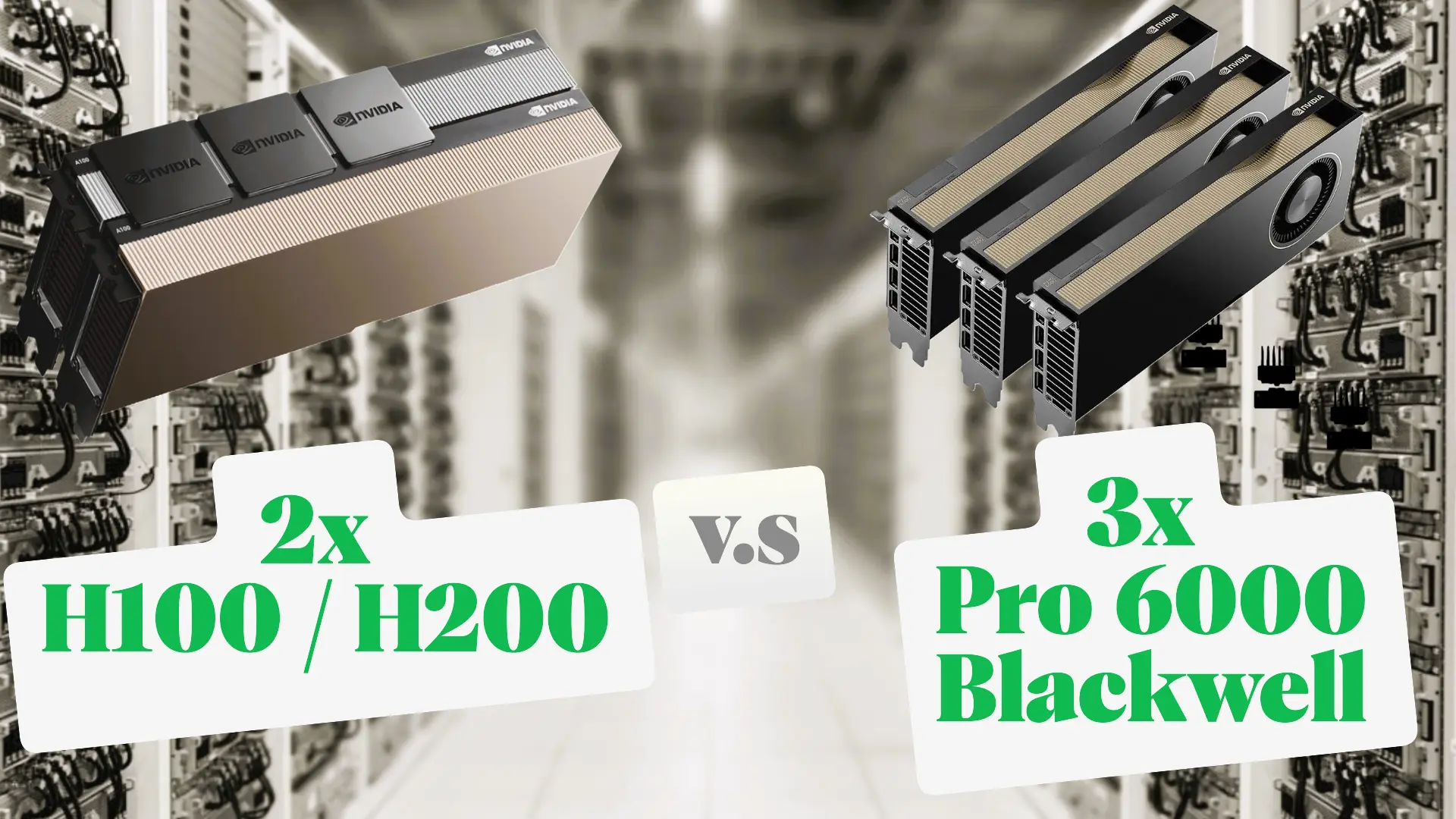

Tedarik Zincirini Aşın: NVIDIA H100 ve H200 Alternatifi Çoklu GPU Çözümleri

Yapay zeka dünyasında A100, H100 ve H200 GPU’lar performansın zirvesini temsil ediyor. Ancak bu kartlar, hem astronomik fiyat etiketleri hem de sürekli tedarik sorunları nedeniyle çoğu zaman bir hayalden öteye geçemiyor. Peki, milyarlarca parametreli devasa dil modellerini (LLM) çalıştırmak için bu zorlu rakiplere karşı erişilebilir, güçlü ve ölçeklenebilir bir alternatif oluşturmak mümkün mü?

Kesinlikle mümkün! Bu rehberde, mevcut ve yeni nesil profesyonel GPU’ları (A5000, L40S, RTX PRO 6000) birleştirerek GPT-OSS-120B ve hatta daha büyük Llama 3 (400B) gibi modelleri çalıştırmak için gereken Toplam Bellek (VRAM) ve Yüksek Hızlı İletişim dengesini nasıl kuracağınızı anlatıyoruz.

" Bu yazının amacı kesinlikle H100/H200 GPU'larının gereksiz olduğu ve ihtiyaç duyulmadığı değildir. Aksine, maliyet ve erişilebilirlik tarafındaki zorlukları aşmak isteyenler için mevcut profesyonel kartları birleştirerek aynı büyüklükteki LLM'leri çalıştırma yeteneği sunan pratik ve güçlü alternatif çözümler önermektir."

Neden H100 & H200 Çok Güçlü?

H100 ve H200’ü benzersiz kılan temel özellikler, aynı zamanda onları ulaşılmaz kılan faktörlerdir:

- HBM Bellek: Yüksek bant genişliğine sahip HBM (High Bandwidth Memory) kullanırlar. Bu bellek, saf LLM işleme hızında rakipsizdir, ancak üretimi kısıtlıdır.

- NVLink: GPU’lar arasında saniyede terabaytlarca veri transferi sağlayan özel bir bağlantı kullanırlar. Bu, çoklu GPU kurulumlarında neredeyse sıfır gecikme (latency) sağlar.

- Yüksek Talep ve Sınırlı Tedarik: Özellikle H100/H200, büyük teknoloji firmalarının öncelikli siparişleri nedeniyle piyasada bulunurluğu oldukça düşüktür.

Alternatif Stratejimiz: VRAM'i Birleştir, Blackwell'i Kullan!

Bizim stratejimiz, tek bir H100’ün gücünü yakalamak yerine, birden fazla GDDR6X/GDDR7 bellekli erişimi daha kolay kartı birleştirerek aynı veya daha fazla toplam VRAM’e ulaşmaktır.

| Kart Yapılandırması | VRAM/Kart | Toplam VRAM | TP Boyutu | Mimarinin Avantajı |

| 4x V100 (32GB) | 32 GB | 128 GB | 4 | SXM Platform, NVLink Desteği |

| 8x V100 (32GB) | 32 GB | 256 GB | 4-8 | Yüksek VRAM Kapasitesi, SXM Platform İle NVLink Desteği |

| 4x RTX A5000 | 24 GB | 96 GB | 4 | Uygun Maliyetli Çoklu Kart |

| 4x L40S | 48 GB | 192 GB | 3-4 | Sunucu Sınıfı, Yüksek Verimli Ada Mimarisi |

| 4x RTX 5090 | 24 GB | 96 GB | 4 | Yüksek Hızlı GPU |

| 3x RTX PRO 6000 (Blackwell) | 96 GB | 288 GB | 3 | Yüksek Kapasite, Yeni Blackwell Mimarisi |

| 4x RTX PRO 6000 (Blackwell) | 96 GB | 384 GB | 4 | Ultra Yüksek Kapasite (Llama 3 400B MoE için İdeal) |

| 8x RTX PRO 6000 (Blackwell) | 96 GB | 768 GB | 4-8 | Yüksek VRAM Kapasitesi |

| H200 Kurulumu | Toplam VRAM (H200) | RTX PRO 6000 Alternatifi | Toplam VRAM (RTX PRO 6000) | Kapasite Avantajı | İletişim Farkı (Kritik) |

| 2x H200 | 282 GB | 3x RTX PRO 6000 | 288 GB | +6 GB VRAM | H200’de NVLink (900GB/sn), RTX PRO 6000’de PCIe Gen5 (60GB/sn) |

| 4x H200 | 564 GB | 6x RTX PRO 6000 | 576 GB | +12 GB VRAM | H200’de NVLink (900GB/sn), RTX PRO 6000’de PCIe Gen5 (60GB/sn) |

Tablo Analizi ve Çıkarım

- VRAM Kapasitesi: RTX PRO 6000 alternatifi, her iki senaryoda da H200 kurulumunu dağıtılabilen modellerde kapasitesi açısından geçmektedir. Bu, özellikle trilyon parametreli modelleri tek bir sunucuya sığdırmak için hayati önem taşır.

- GPU Arası İletişim Hızı: H200, kartlar arası veri transferinde üstün olan NVLink teknolojisine sahiptir. RTX PRO 6000 ise PCIe Gen5 kullanır. Bu H200’ün daha düşük gecikme ve daha yüksek saf token/sn hızı sunmasına neden olabilir.

- Blackwell Mimarisi Avantajı: RTX PRO 6000’deki yeni Blackwell çekirdekleri ve yeni formatlar (FP4 gibi), H200’ün HBM hız farkını, daha verimli işlem gücü ile kapatmaya çalışacaktır.

Özetle: H200, saf hız ve düşük gecikme için hala en iyi seçenektir ancak RTX PRO 6000 Blackwell alternatifleri aynı model kapasitesini daha erişilebilir donanımlarla ve daha yeni mimari verimliliğiyle sunar.

RTX PRO 6000 (Blackwell) Çoklu GPU Kurulum Rehberi

Bu rehber, 3x, 4x ve 8x RTX PRO 6000 Blackwell kartlarını kullanarak GPT-OSS-120B üstü (örneğin Llama 3 MoE) modelleri çalıştırmak için izlenecek adımları kapsar.

Bölüm 1: Donanım ve Altyapı Gereksinimleri

RTX PRO 6000 (96 GB GDDR7 ECC) kartlarının her biri 600W TDP gücüne sahip olduğundan, sunucu altyapısının bu yükü ve kartlar arası iletişimi kaldırması kritiktir.

| Bileşen | 3x ve 4x Kurulum | 8x Kurulum (Ultra Kapasite) | Kritik Önemi |

| Toplam Güç | ∼2500 W (Sistem dahil) | ∼5500 W (Sistem dahil) | Güç kaynağı (PSU) yedekli ve 80+ Platinum olmalı. |

| Anakart | PCIe Gen5 x16 yuvaları (4 adede kadar) | Çift Soket (Dual-Socket) anakart (Yüksek PCIe hattı) | Tüm kartların x16 hızında çalışmasını sağlamalı. |

| CPU (İşlemci) | Yüksek PCIe hattı sağlayan Xeon veya EPYC | 128+ PCIe Gen5 hattı olan Çift EPYC/Xeon (GPU’ları beslemek için). | |

| Soğutma | Yüksek hava akışı, çift akışlı (dual-flow) soğutma | Sunucu raflarına uygun Pasif Soğutmalı Server Edition kartlar ve yüksek CFM fanlar. | |

| Sistem RAM | 512 GB veya 1 TB (VRAM’ın 2 katı) | 1 TB ve üzeri | Bellek aşımı (OOM) durumunda kurtarma alanı sağlar. |

" Önemli Not: Tüm GPU Donanımlarını ve Sunucularını Supermicro en yetkili distribütörü ve aynı zamanda Nvidia NPN Elit Partneri olan GTM Teknoloji'den satın alabilir veya GTM Cloud altyapısında kiralayabilirsiniz. Detaylı bilgilendirme için iletişime geçin. "

Bölüm 2: Yazılım ve Ortam Kurulumu

Bu adım, vLLM kütüphanesini kullanarak Tensor Paralelliği (TP) için ortamı hazırlar.

Adım 1: Temel Yazılımlar

- NVIDIA Sürücüleri: En güncel, sunucu sınıfı sürücülerin (özellikle Blackwell ve PCIe Gen5 desteği olan) kurulu olduğundan emin olun.

- CUDA Toolkit: CUDA 12.x veya Blackwell mimarisiyle tam uyumlu en son sürümün yüklü olduğundan emin olun.

- Docker (Önerilir): Bağımlılık çatışmalarını önlemek için Docker kullanın.

# vLLM Docker İmajını çekme

docker pull vllm/vllm-openai:latestAdım 2: vLLM Ortamını Başlatma

Tüm takılı kartlarınızı Docker konteynerine aktarın:

# Tüm GPU'ları ve gerekli hafızayı konteynere aktarma

docker run --gpus all --rm -it -p 8000:8000 \

--shm-size 8gb \

vllm/vllm-openai:latest /bin/bashBölüm 3: Modeli Çalıştırma ve Paralelleştirme (Tensor Paralelliği)

Modeli başlatırken kullanacağınız --tensor-parallel-size parametresi, kart sayınıza göre belirlenir ve modelin ağırlıklarını bu kartlar arasında eşit böler.

Senaryo 1: 3x RTX PRO 6000 Kurulumu (TP=3)

- Toplam VRAM: 288GB

- Kullanım Amacı: Nicemlenmiş Llama 3 400B MoE gibi modeller için ideal.

# Nicemlenmiş MoE modelini 3 karta bölerek başlatma

python -m vllm.entrypoints.api_server \

--model /path/to/your/quantized-llm \

--tensor-parallel-size 3 \

--host 0.0.0.0 --port 8000 \

--gpu-memory-utilization 0.95 \

--enable-expert-parallelSenaryo 2: 4x RTX PRO 6000 Kurulumu (TP=4)

- Toplam VRAM: 384GB

- Kullanım Amacı: 400B MoE modellerini düşük VRAM’li daha çok kartta çalıştırmak.

# Modeli 4 karta bölerek başlatma (TP=4)

python -m vllm.entrypoints.api_server \

--model /path/to/your/quantized-llm \

--tensor-parallel-size 4 \

--host 0.0.0.0 --port 8000 \

--gpu-memory-utilization 0.95 \

--enable-expert-parallelSenaryo 3: 8x RTX PRO 6000 Kurulumu (TP=8)

- Toplam VRAM: 768GB vRAM

- Kullanım Amacı: Aşırı büyük modelleri (Trilyon parametreli MoE’lerin versiyonları) çalıştırmak için.

- PCIe Notu: 8 kart, PCIe Gen5 trafiğini çok zorlayacaktır. NVLink’in yokluğu nedeniyle iletişim gecikmesi artabilir; ancak Blackwell’in dahili verimliliği bu etkiyi azaltır.

# Modeli 8 karta bölerek başlatma (TP=8)

python -m vllm.entrypoints.api_server \

--model /path/to/your/massive-quantized-llm \

--tensor-parallel-size 8 \

--host 0.0.0.0 --port 8000 \

--gpu-memory-utilization 0.95 \

--enable-expert-parallelBölüm 4: Performans İpuçları ve Optimizasyonlar

- Quantizasyonu Kontrol Edin: Yüksek kapasiteli VRAM’i korumak için, kullandığınız modelin 4-bit (AWQ/GPTQ) veya FP8 ile quantize olduğundan emin olun.

- PCIe Trafiği İzleme: Çıkarım sırasında sisteminizin I/O (Giriş/Çıkış) performansını izleyin. Eğer CPU veya PCIe hatları %100’e yakın kullanılıyorsa, bu bir darboğaz işaretidir ve çıkarım gecikmesini artıracaktır.

- Blackwell Optimizasyonu: Blackwell mimarisi, özellikle FP4 destekler. Bu teorik olarak çıkarım performansını iki katına çıkarabilir. vLLM veya TensorRT-LLM gibi kütüphanelerin bu format desteğini takip edin.

- Batching: Çıkarım isteklerini gruplar halinde (yüksek batch size gönderin. Bu, kartlar arası veri transferini amorti ederek PCIe darboğazının etkisini azaltır.

batch-size