NVIDIA Tesla GPU Modelleri ve Özellikleri

Dünyanın En Gelişmiş

Veri Merkezi GPU'ları

NVIDIA ® Tesla ® GPU’lar en zorlu HPC ve aşırı ölçekli veri merkezi iş yüklerinizi hızlandırır . Veri bilimcileri ve araştırmacılar, artık enerji araştırmalarından derinlemesine öğrenmeye kadar değişen uygulamalarda, geleneksel CPU’ları kullandıklarından daha hızlı veri sıralarının petabaytlarını ayrıştırabilirler . Tesla hızlandırıcıları ayrıca daha büyük simülasyonları her zamankinden daha hızlı çalıştırmak için gereken hesaplama gücünü sağlar. Ayrıca, Tesla sanal masaüstleri, uygulamalar ve iş istasyonları için en yüksek performansı ve kullanıcı yoğunluğunu sunar.

NVIDIA Tensor T4 GPU

NVIDIA ® T4 GPU, yüksek performanslı bilgi işlem, derin öğrenme eğitimi ve çıkarım, makine öğrenmesi, veri analitiği ve grafikler de dahil olmak üzere çeşitli bulut iş yüklerini hızlandırır. Yeni NVIDIA Turing ™ mimarisine dayanan ve enerji tasarruflu 70 watt’lık küçük bir PCIe form faktörü içinde paketlenmiş olan T4, ölçeklenebilir bilgi işlem ortamları için optimize edilmiştir ve çok hassas Turing Tensor Çekirdekleri ve yeni RT Çekirdekleri içerir. NGC’nin hızlandırılmış konteyner yazılım yığınlarıyla birleştirilen T4, ölçekte devrimsel performans sunuyor.

Performansın Sınırları Aşıldı

T4, çeşitli iş yüklerini ele almak için çok hassasiyetli bilgi işlem teknolojisine sahip devrim niteliğindeki Turing Tensor Core teknolojisini sunar. FP32’den FP16’dan INT8’e ve çığır açan performansın yanı sıra INT4 hassasiyetlerine güç veren T4, CPU’lardan 40 kata kadar daha yüksek performans sunar.

GTM Teknoloji - GPU Sunucular ile Uygulamanızın hızlandırılıp hızlandırılmadığını bulun.

NVIDIA TESLA V100 DATACENTER GPU

YAPAY ZEKA / DERİN ÖĞRENME / GPU HESAPLAMA

NVIDIA ® Tesla ® V100 Tensör Çekirdeği

AI’yı hızlandırmak için şimdiye kadar üretilmiş en gelişmiş veri merkezi GPU’su,yüksek performanslı bilgi işlem (HPC) ve grafikler. NVIDIA Volta mimarisiyle güçlendirilmiş , 16 ve 32GB yapılandırmalarla geliyor ve tek bir GPU’da 100 CPU’ya kadar performans sunuyor. Veri bilim adamları, araştırmacılar ve mühendisler şimdi bellek kullanımını optimize etmek için daha az, bir sonraki AI atılımını tasarlamak için daha fazla zaman harcayabilirler.

YÜKSEK PERFORMANSLI BİLGİ İŞLEME (HPC)

HPC, modern bilimin temel bir dayanağıdır. Araştırmacılar, hava tahmininden uyuşturucuyu keşfetmeye, yeni enerji kaynakları bulmaya, dünyayı canlandırmak ve tahmin etmek için büyük bilişim sistemleri kullanıyor. AI, araştırmacıların yalnızca simülasyonun gerçek dünyayı tam olarak öngöremediği hızlı bilgiler için büyük miktardaki verileri analiz etmelerine izin vererek geleneksel HPC’yi genişletir.

Tesla V100, AI ve HPC’nin yakınsaması için tasarlanmıştır. HPC sistemlerinin, bilimsel simülasyon için hem bilgi işlem biliminde hem de verilerde içgörü bulmak için veri biliminde üstün olması için bir platform sunar. NVIDIA CUDA ® çekirdeği ile Tensor Çekirdeğini birleşik bir mimaride eşleştirerek , Tesla V100 GPU’lu tek bir sunucu, hem geleneksel HPC hem de AI iş yükleri için yüzlerce emtia işlemcili sunucuyu değiştirebilir. Her araştırmacı ve mühendis şimdi en zorlu işleriyle başa çıkmak için bir AI süperbilgisine sahip olabilirler.

GTM Teknoloji - GPU Sunucular ile Uygulamanızın hızlandırılıp hızlandırılmadığını bulun.

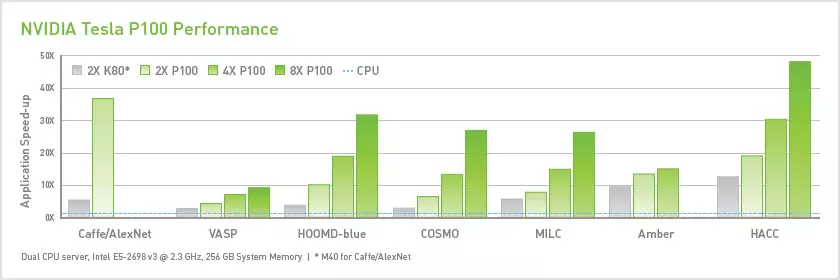

NVIDIA TESLA P100

Dünyanın İlk AI Süper Hesap Veri Merkezi GPU'su

MODERN BİLGİ MERKEZİ İÇİN SINIRSIZ BİLGİSAYAR GÜCÜ

Günümüzün veri merkezleri, yüksek performanslı bilgi işlem (HPC) ve aşırı ölçekli iş yüklerini sınırlayan, birbirine bağlı birçok emtia işlem düğümüne dayanmaktadır.

NVIDIA ® Tesla ® P100 içine musluklar NVIDIA Pascal ™ GPU mimarisi dramatik olarak artan maliyetlerinizi düşürürken, HPC ve AI verimi artırmak için birleşik bir platform sunar.

UYGULAMA PERFORMANSININ YENİ BİR SEVİYESİ

550’den fazla HPC uygulaması ile hızlandırılmış (en iyi 15’ten 15’i) ve tüm derin öğrenme çerçeveleriyle NVIDIA NVLink’liTesla P100, 50X’e kadar performans artışı sağlıyor.

TESLA P100 ÜRÜNLERİ

Güçlü Ölçekli HPC için NVIDIA Tesla P100

NVIDIA NVLink teknolojisine sahip Tesla P100, yıldırım hızında çalışan düğümlerin güçlü ölçekli uygulamalar için çözüme yönelik zamanı önemli ölçüde hızlandırmasını sağlar.

NVLink’li bir sunucu düğümü, 5X’te PCIe’nin bant genişliğinde sekiz adete kadar Tesla P100’ü birbirine bağlayabilir. HPC ve derin öğrenme konusunda sınırsız bilgi işlem gereksinimi olan dünyanın en önemli zorluklarını çözmeye yardımcı olmak için tasarlanmıştır.

Karışık İş Yükü HPC için NVIDIA Tesla P100

PCIe için Tesla P100, karışık iş yükü HPC veri merkezlerinin para tasarrufu sağlarken verimde çarpıcı bir sıçrama gerçekleştirmesini sağlar. Örneğin, PCIe ile birbirine bağlanan dört Tesla P100 tarafından desteklenen tek bir GPU ile hızlandırılmış bir düğüm, çeşitli uygulamalar için 32’ye kadar emtia CPU düğümünün yerini almaktadır. Tüm işleri çok daha az sayıda güçlü düğümle tamamlamak, müşterilerin genel veri merkezi maliyetlerinde yüzde 70’e kadar tasarruf edebileceği anlamına gelir.

NVIDIA DATA CENTER INFERENCE ÜRÜNLERİ

TESLA T4

NVIDIA ® Tesla ® T4 grafik işlemcisi, yüksek performanslı işlem, derin öğrenme, eğitim ve çıkarımlar ve otomatik öğrenme, veri analizi ve grafikler de dahil olmak üzere çeşitli bulut yüklerini, hızlandırır. Yeni NVIDIA’nın yeni Turing ™ mimarisine dayanan ve enerji tasarruflu 70 watt’lık küçük bir PCIe form faktörü içinde paketlenmiş olan T4, ölçeklendirilebilir sunucuların ölçeklendirildiği bilgisayar ortamları için optimize edilmiştir. Ayrıca, çok hassasiyetli Turing Tensor Cores ve NVIDIA GPU Cloud’un hızlandırılmış kaplanmış yazılım yığınlarıyla bir araya geldiğinde Tesla T4, ölçekte devrimsel performans sağlayan yeni RT Corres’e de sahip.

Evrensel Veri Merkezleri İçin TESLA V100

Tesla V100, GPU başına 125 teraflop çıkarım performansına sahiptir. Sekiz Tesla V100’e sahip tek bir sunucu bir bilgi işlem petaflopu üretebilir.

Ultra Verimli Ölçeklendirmeli Sunucular İçin TESLA P4

Tesla P4, herhangi bir ölçeklendirme sunucusunu hızlandırır ve CPU’lara kıyasla 60 kat daha yüksek enerji verimliliği sunar.

Çıkarımlı Sunucular İçin TESLA P40

Tesla P40, şaşırtıcı bir kullanıcı deneyimi için mükemmel çıkarım performansı, INT8 hassaslığı ve 24 GB dahili bellek sunar.

NVIDIA DATA CENTER BİLGİSAYAR YAZILIMI

NVIDIA TensorRT

NVIDIA TensorRT , yalnızca CPU’lu mimarilere kıyasla , danışmanlar , konuşma tanıma ve makine çevirisi gibi uygulamaları hızlandırabilen yüksek performanslı bir sinir ağı çıkarım platformudur. TensorRT sinir ağı modellerini optimize eder, düşük hassasiyet için yüksek hassasiyetle kalibre eder ve modelleri kurumsal ve hiper ölçekli veri merkezlerinde üretim ortamlarına dağıtır.

NVIDIA TensorRT Çıkarım Sunucusu

NVIDIA TensorRT Çıkarım Sunucusu , uygulamaların veri merkezi üretiminde AI modellerini kullanmalarına izin veren bir mikro hizmettir . GPU kullanımını maksimuma çıkarır ve aynı anda bir düğümde aynı anda farklı çerçevelerden birden fazla model çalıştırır. TensorRT Inference Server, tüm popüler AI modellerini ve çerçevelerini destekler ve DevOps mimarilerine sorunsuz bir şekilde entegre olmak için Docker ve Kubernet’lerden yararlanır. NGC konteyner sicilinden kullanıma açılmaya hazır bir konteyner olarak ve açık kaynaklı bir proje olarak mevcuttur .

NVIDIA GPU’larda Kubernet’ler

NVIDIA GPU’lardaki Kubernet’ler , işletmelerin çoklu bulut GPU kümelerine yönelik eğitim ve çıkarım dağılımını sorunsuz bir şekilde ölçeklendirmelerini sağlar. Kubernet’lerle, GPU hızlandırmalı derin öğrenme ve yüksek performanslı bilgi işlem (HPC) uygulamaları anında çoklu bulut GPU kümelerine dağıtılabilir.

DeepStream SDK

Tesla için NVIDIA DeepStream , akıllı şehirler ve yüksek ölçekli veri merkezleri için derin öğrenmeye dayalı ölçeklenebilir akıllı video analitiği (IVA) uygulamaları oluşturmak için kullanılan bir SDK’dır. Tesla GPU’ların gücünden yararlanmak için NVIDIA TensorRT optimizer ve çıkarım için çalıştırma motorları, transcode için Video Codec SDK, ön işleme ve veri işleme API’lerini bir araya getiriyor. Örneğin, Tesla P4 GPU’larda, eşzamanlı olarak 30 HD video akışını aynı anda kodlayabilir ve analiz edebilirsiniz.

ÖZELLİKLER VE FAYDALAR

En Gelişmiş AI Çıkarım Platformu

NVIDIA Turing Tensor Cores tarafından desteklenen Tesla T4, FP32, FP16, INT8 ve INT4’te çıkarım için yapılan derinlemesine eğitim için çığır açan performans sunar. 130 TeraOPS (TOPS) INT8 ve 260TOPS INT4 ile T4, CPU’lara kıyasla 40 kat daha fazla olan dünyanın en yüksek çıkarım verimliliğine sahiptir. Tesla T4, donanım hızlandırmalı özel video dönüştürme motorları kullanarak gerçek zamanlı olarak aynı anda 39’a kadar HD video akışını analiz edebilir. Geliştiriciler, video aramayı ve video ile ilgili diğer hizmetleri kolaylaştıran çıkarımı kullanarak yeni akıllı, yenilikçi işlevsellik seviyeleri sunabilir. Tüm bu performansı 70 watt (W) seviyesine getirmek, Tesla T4’ü uçtaki sunucular için ideal çıkarım çözümü yapar.

24X İş Yüklerini Genişletmek İçin Daha Yüksek Verim

NVIDIA Volta ™ tarafından desteklenen Tesla V100 GPU’lar, veri merkezlerine, günümüzün tsunami verilerinden istihbarat çıkarmak için derin öğrenme iş yüklerinde verimlilik artışı sağlar. Tek bir Tesla V100’e sahip bir sunucu, derin öğrenme çıkarımı iş yükleri için yalnızca 50 CPU’ya kadar sunucunun yerini alabilir, böylece daha düşük edinim maliyeti ile önemli ölçüde daha yüksek verim elde edersiniz.

NVIDIA TensorRT ve DeepStream SDK ile Performansı En Üst Düzeye Çıkarın

NVIDIA TensorRT optimize edici ve çalışma zamanı motorları, öneri sistemleri, konuşma tanıma ve makine çevirisi gibi uygulamalar için düşük gecikme süresi boyunca yüksek seviyede sunar. TensorRT ile, 32-bit veya 16-bit verilerde eğitim almış modeller Tesla T4 ve P4’teki INT8 veya Tesla V100’deki FP16 için optimize edilebilir. NVIDIA DeepStream SDK , aynı anda video akışlarının kodunu çözmek ve analiz etmek için Tesla GPU’ların gücünden yararlanıyor.

GPU Kullanımını En Üst Düzeye Çıkarır ve Tüm Üst Çerçeveleri Destekleyen Çıkarım

NVIDIA TensorRT Inference Server, yüksek verimli veri merkezi çıktısı sunar ve GPU’larınızdan en iyi şekilde yararlanmanıza yardımcı olur. Çalışmaya hazır bir kapta teslim edilen NVIDIA TensorRT Inference Server, Caffe2, NVIDIA TensorRT, TensorFlow ve herhangi bir modelin kombinasyonu için bir API üzerinden çıkarım gerçekleştirmenizi sağlayan bir mikro hizmettir ve bir veya daha fazla ONNX standardını destekleyen herhangi bir çerçeve GPU’lar.

PERFORMANS ÖZELLİKLERİ

Tesla T4: Dünyanın En Gelişmiş Çıkarım HızlandırıcıTesla V100: Evrensel Veri Merkezi GPUVerimli, Ölçeklendirilebilir Sunucular için Tesla P4Çıkarımlı Sunucular için Tesla P40

|

Tek Hassasiyet Performansı (FP32) |

8.1 TFLOPS 14 TFLOPS (PCIe) 15.7 teraflop (SXM2) 5.5 TFLOPS 12 TFLOPS |

|

Yarı Hassasiyet Performansı (FP16) |

65 TFLOPS

112 TFLOPS (PCIe) 125 TFLOPS (SXM2) – – |

| Tamsayılı İşlemler (INT8) |

130 TOPS – 22 TOPS * 47 TOPS * |

|

Tamsayılı İşlemler (INT4) |

260 TOPS – – – |

|

GPU Belleği |

16 GB 32 / 16GB HBM2 8GB 24GB |

| Hafıza Bant Genişliği |

320 / s 900GB / sn 192 GB’a / sn 346GB / sn |

| Sistem Arabirimi / Form Faktörü |

Düşük Profilli PCI Express Form Faktörü Çift Yuvalı, Tam Yükseklikte PCI Express Form Faktörü SXM2 / NVLink Düşük Profilli PCI Express Form Faktörü Çift Yuvalı, Tam Yükseklikte PCI Express Form Faktörü |

|

Güç |

70 W 250 W (PCIe) 300 W (SXM2) 50 W / 75 W 250 W |

|

Donanım Hızlandırılmış Video Motoru |

1x Kod Çözme Motoru, 2x Kodlama Motorları – 1x Kod Çözme Motoru, 2x Kodlama Motorları 1x Kod Çözme Motoru, 2x Kodlama Motorları |